Le débat éthique est caractérisé par une approche centrée sur les risques. Bien que ceux-ci varient d’un secteur à l’autre, pour les entreprises actives dans le domaine de l’IA, les principaux risques sont ceux liés à leur réputation, à leur valorisation sur les marchés boursiers, et aux condamnations éventuelles dès lors que leurs activités enfreindraient les périmètres définis par la loi. Mais les risques sont aussi ceux du coût pour l’environnement : les technologies de l’IA sont très gourmandes en ressources et les « data center » sont particulièrement énergivores. Selon une étude de l’Institut Allen pour l’intelligence artificielle, l’entraînement d’un système de génération et reconnaissance du langage naturel (le nôtre) est émet autant de dioxyde de carbone que cinq voitures tout au long de leur vie. Quant aux technologies blockchain, caractérisées par la décentralisation du stockage et de la transmission de données, leur coût environnemental donne le vertige : par exemple, l’emprunte carbone du Bitcoin est comparable à celle du Qatar, sa consommation en électricité est comparable à celle de la Pologne et sa consommation en eau est comparable à celle de la Suisse. Les IA génératives ajoutent également leur lourde emprunte environnementale, et les besoins en électricité sont tells que big tech pense sérieusement investir dans l’énergie nucléaire. A une époque où les défis environnementaux sont majeurs pour la préservation de l’habitabilité de la planète, tout ceci pose question.

Dans le secteur des soins de santé, les technologies de l’IA se sont montrées très performante pour, par exemple, découvrir des cellules cancéreuses. Elles sont aussi utilisées, en télémédecine, via des robots dont l’objet est de réduire la sensation de solitude et d’isolement des personnes âgées. Pour celles souffrant de démence, le risque est de ne pas se rendre compte que le robot n’est rien de plus qu’un robot. Dans le domaine de la justice, les algorithmes prédictifs rendent des décisions susceptibles de reproduire des biais humains, dès lors qu’ils s’appuient sur des données composées de jugements antérieurs (aux États-Unis, les biais raciaux sont souvent épinglés). La question des biais se pose également dans le secteur des banques et assurances, mais aussi dans celui du recrutement. Est-il humainement acceptable d’être mis sur la touche sur base de la décision froide d’un algorithme ? De nombreuses études ont également souligné les risques sur l’emploi : si une machine fait le job, pourquoi une entreprise aurait-elle encore besoin de rémunérer des humains ? Il s’agit ici d’une nouvelle révolution industrielle qui concerne l’ensemble des professions et si certains types d’emplois sont voués à disparaître, inévitablement, de nouveaux sont en train de voir le jour. N’oublions pas que derrière tout système informatique, il se trouve toujours des humains qui définissent des règles et des procédures.

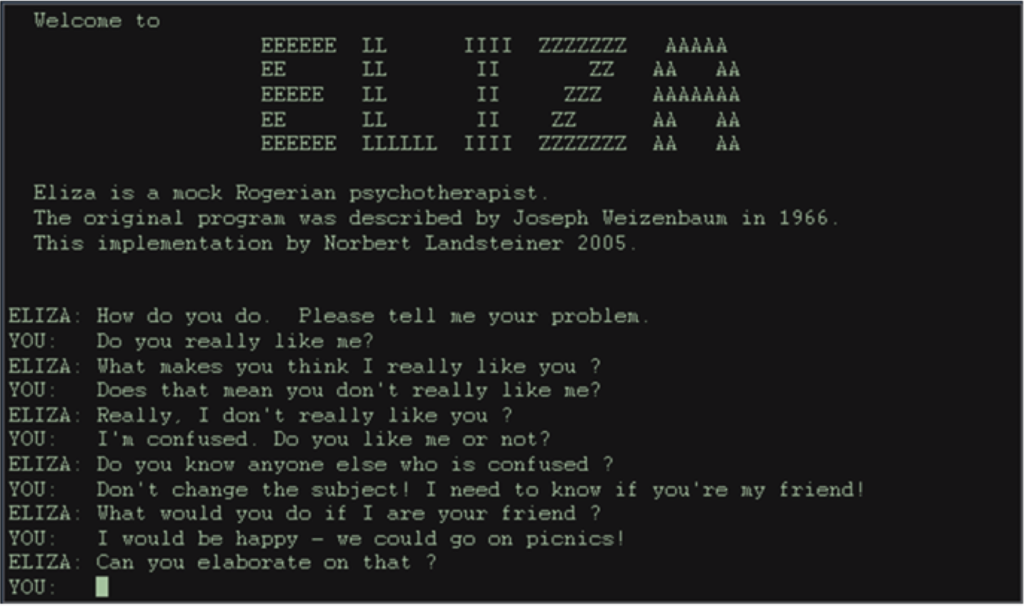

A ce catalogue, ajoutons les risques psychologiques induits par des liens affectifs qu’un utilisateur tisserait avec son assistant personnel. Le premier chatbot est né dans les années 1970. Il s’appelait Eliza. Il s’agissait d’un système de psychothérapie de type rogérien consistant à reformuler des affirmations en questions. Eliza ne faisait que rédiger mais elle était si convaincante que certains utilisateurs en sont devenus dépendants. Plus proche de nous, la presse a déjà fait état d’agents conversationnels ayant recommandé à leur utilisateur de se suicider.

Le risque ultime est celui de la mise en danger de la vie d’autrui. Dans le contexte des véhicules autonomes, les questions de responsabilité et de sécurité sont régulièrement mises en avant. En principe, le conducteur est le seul responsable de son véhicule. Mais ce principe est-il suffisant lorsqu’un accident est causé par une défaillance du logiciel ? Par ailleurs, ces véhicules collectent d’énormes quantités de données sur leur utilisation. Mais celles-ci sont aussi essentielles pour en évaluer leurs performances et améliorer leur sécurité. Dans le monde de l’intelligence artificielle et en robotique, l’autonomie se rapporte à un système ayant la capacité de fonctionner sans opérateur humain pendant une période prolongée.

Les armes autonomes font partie des technologies de l’IA les plus contestées, dès lors que leur pouvoir de décision est aussi celui de la vie et de la mort de cibles humaines. Leurs bénéfices sont ceux de pouvoir être utilisées dans des opérations de déminage, de neutralisation d’explosifs ou des missions de sauvetage ou d’assistance. Mais elles peuvent aussi tuer, et cette décision est susceptible de contenir des biais ou des facteurs discriminants. Une arme autonome devrait être capable de distinguer les combattants des non-combattants, de calculer la proportionnalité, et de respecter le principe de commandement pour prévenir des atrocités. Mais pour la coalition campagne Stop Killer Robots, la mort par algorithme est l’ultime indignité : le droit de l’humain est celui de ne pas être tué par une machine.

C’est dans l’optique d’une approche basée sur les risques que le Parlement européen a approuvé l’IA Act. Ce règlement propose une classification des systèmes d’IA en quatre niveaux de risque : inacceptable, haut, spécifique en matière de transparence, et faible. Les systèmes à risque inacceptable, tels que la notation sociale ou l’exploitation de la vulnérabilité des personnes, sont strictement interdits. Les systèmes à haut risque, comme ceux utilisés dans le recrutement ou à des fins répressives, sont soumis à des exigences renforcées, notamment des évaluations de conformité et des mécanismes de gestion des risques. Cette approche vise à garantir que le développement et l’utilisation de l’IA en Europe soient conformes aux valeurs de l’Union et respectent les droits fondamentaux, tout en favorisant un innovation responsable.