Carte blanche présentée lors de la Conférence Nationale des Métiers du Journalisme (CNJM), organisée à l’école de journalisme de Tours, le 29 janvier 2026.

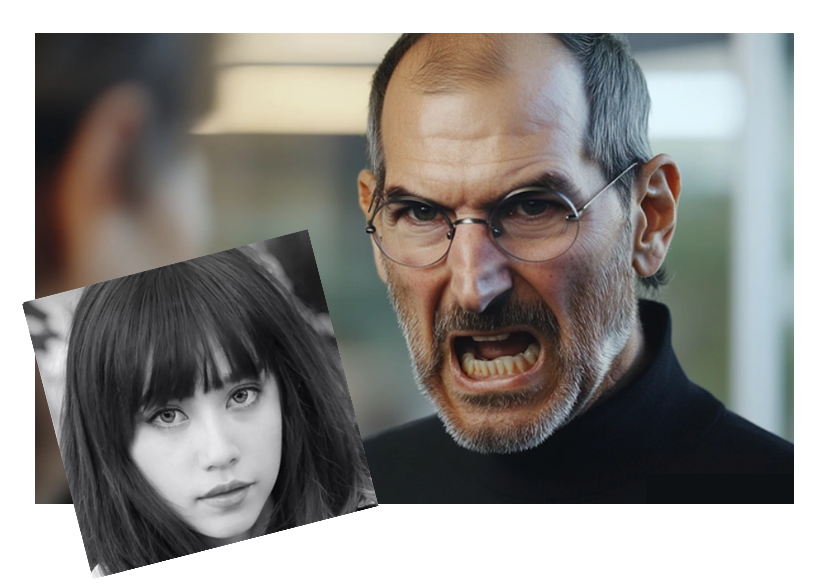

Les deux images que vous voyez à l’écran illustrent bien les dérives possibles de l’usage des technologies d’intelligence artificielle générative dans les médias. La femme est une journaliste… qui n’existe pas et dont les articles ont été générés par un modèle de langage pour un célèbre magazine féminin. L’homme, lui, est décédé. Cette photo de lui n’existe pas dans la réalité. Elle a été générée pour illustrer un article post mortem.

Depuis le lancement officiel de ChatGPT, il y a un peu plus de trois ans, jamais on n’a autant parlé d’éthique journalistique. Pourtant, l’intelligence artificielle n’est pas née avec les IA génératives. Elle est présente depuis des années dans les médias, souvent dans un mélange de crainte et d’enthousiasme.

Ce qui change aujourd’hui, c’est la puissance et l’accessibilité des outils génératifs, capables de produire des textes, des images, des sons, des vidéos en quelques secondes. Les inquiétudes sont d’autant plus profondes que ces mêmes outils sont devenus des instruments de création et d’amplification de désinformation.

Les frontières entre la réalité et la fiction n’ont jamais été aussi ténues et elles remettent en question notre rapport au réel, notre rapport aux faits. Ces évolutions bousculent les pratiques et repères professionnels. Et elles posent une question centrale : l’éthique journalistique est-elle mal en point ?

2.

L’éthique journalistique a toujours été mise sous tension. En 2009, Daniel Cornu posait la question centrale du rapport entre le journalisme et la vérité. Il soulignait que le journalisme se réclame traditionnellement de la vérité, mais que cette revendication est fragilisée par de multiples critiques : erreurs médiatiques, manipulations, pressions économiques et politiques, défiance croissante du public.

Entre l’idéal de vérité auquel aspirent les journalistes et les conditions concrètes de production de l’information, il y a un écart structurel qui est toujours présent aujourd’hui. La quête de la vérité apparaît moins comme un objectif pleinement réalisable que comme un horizon normatif, constamment mis à l’épreuve par les réalités du terrain.

En 2016, dans son manuel d’éthique de journalisme, Benoît Grevisse abordait l’éthique et la déontologie du journalisme non pas comme des règles strictes, mais comme des principes réflexifs et professionnels qui s’inscrivent dans la production quotidienne de l’information.

L’éthique est un espace de questionnement permanent, au sein duquel les journalistes sont amenés à arbitrer des valeurs professionnelles, telles que la vérité, l’indépendance ou la responsabilité sociale, et des contraintes organisationnelles, économiques et symboliques.

Cornu et Grevisse montrent, chacun à leur manière, que l’éthique journalistique ne se réduit ni à une proclamation de principes ni à un respect formel de règles. Elle se construit dans l’action, à travers des choix situés, souvent imparfaits, mais essentiels pour préserver la crédibilité et la légitimité de l’information dans l’espace public.

3.

L’intégration progressive des technologies d’intelligence artificielle dans les rédactions ne remet pas fondamentalement en question les paradigmes classiques de l’éthique journalistique. Les questions de vérité, de responsabilité, d’indépendance ou de crédibilité restent au cœur du métier. En revanche, l’IA tend aujourd’hui à déplacer le débat public et professionnel, en attirant l’attention sur des enjeux technologiques qui finissent par occulter des problèmes pourtant anciens, structurels et non résolus.

En accélérant la production de contenus, en multipliant les formats et en brouillant davantage les frontières entre information, fiction et mise en scène, l’usage des technologies d’intelligence artificielle renforce les risques de désinformation et de spectacularisation de l’information, tout en posant avec insistance la question de la responsabilité journalistique.

Mais de quelles technologies d’intelligence artificielle parle-t-on, au juste ? Ce terme, très générique, recouvre en réalité une grande variété de technologies qui partagent deux traits communs. D’abord, elles s’appuient sur de vastes ensembles de données pour apprendre. Ensuite, elles ont pour objectif d’imiter certaines capacités cognitives humaines.

Lorsque l’on parle d’IA, on a tendance à se concentrer sur les IA génératives alors que dans les médias, l’intégration des technologies de l’IA ne se limite pourtant pas à ces applications : elle inclut aussi des systèmes prédictifs, des outils d’automatisation, des algorithmes de recommandation et d’autres formes d’assistance à la production et à la diffusion de l’information.

Ces distinctions sont essentielles, parce que les enjeux éthiques ne sont pas les mêmes selon les technologies. Une IA générative, capable de produire du texte ou des images, ne pose pas les mêmes questions qu’un système prédictif ou qu’un algorithme de recommandation.

4.

Cela renvoie, plus largement, à la nécessité de développer une éducation à l’IA ou ce que l’on appelle aussi une littératie de l’IA.

Comprendre l’intelligence artificielle, dans cette perspective, c’est un peu comme ouvrir une poupée russe.

La première couche concerne les compétences techniques et conceptuelles. Il s’agit de comprendre comment ces systèmes fonctionnent, leurs mécanismes, ce qu’ils peuvent faire… mais aussi leurs limites. Sans cette base, il est impossible d’évaluer correctement les risques ou de juger des usages pertinents.

La deuxième couche porte sur les compétences critiques et éthiques. Il ne suffit pas de savoir comment fonctionne un algorithme ou un grand modèle de langage, il faut aussi interroger leurs impacts professionnels. Comment ces technologies influencent-elles la production de l’information, la transparence ou la responsabilité ? Quels biais introduisent-elles et comment affectent-elles les audiences ?

Enfin, la troisième couche concerne les compétences pratiques. Il s’agit ici de développer des usages responsables et réfléchis dans la production et la diffusion de contenus. Cela implique aussi de savoir dire non à certains usages, d’adopter des garde-fous et d’intégrer l’éthique dans les choix du quotidien.

5.

La littératie de l’IA permet de dissiper de grands malentendus, en particulier l’idée selon laquelle les grands modèles de langage fonctionnent comme des bases de données ou qu’ils comprennent de la même manière que les humains. En réalité, il s’agit de systèmes probabilistes qui génèrent des réponses qui sont statistiquement cohérentes. Même si cela fait référence à une architecture complexe et à des jeux de données gigantesques, ces modèles n’ont ni conscience, ni compréhension sémantique. Ils ne font que produire des corrélations calculées.

Cette compréhension des grands modèles de langage était pratiquement absente au moment du lancement de ChatGPT, et c’est ce qui a probablement suscité une vague d’enthousiasme, nourrie par des discours parfois excessifs présentant l’IA tantôt comme une solution salvatrice pour les médias, tantôt comme une menace existentielle pour le journalisme.

La littératie de l’IA permet précisément de déconstruire ces imaginaires techno-solutionnistes et de mieux appréhender les limites et les enjeux d’un usage individuel des technologies. Elle permet aussi de comprendre en quoi les technologies de l’IA peuvent offrir un potentiel lorsqu’elles sont intégrées dans les applications métiers de manière responsable.

En Norvège, par exemple, le projet Demokratibasen vise à utiliser l’intelligence artificielle pour rendre plus accessibles des documents publics et faciliter le travail des journalistes locaux. L’outil propose notamment des analyses automatiques, des résumés de textes et une hiérarchisation des contenus selon leur intérêt journalistique, ce qui permet aux rédactions de gagner du temps et de renforcer leur couverture de l’actualité locale.

6.

Mais il faut garder à l’esprit que nous sommes ici dans un cadre technologique qui dépasse souvent les compétences des journalistes. C’est un point que l’on oublie trop souvent : dans certaines rédactions, des spécialistes du machine learning et de la data participent aux processus éditoriaux en développant des outils, des algorithmes et des systèmes d’automatisation, mais leur contribution est souvent ignorée ou peu intégrée dans les réflexions éthiques.

On se trouve également dans des métiers avec des épistémologies différentes, où certains concepts peuvent avoir des sens distincts selon que l’on parle de journalisme ou de sciences de l’informatique. Par exemple, des notions comme exactitude, objectivité ou transparence peuvent être interprétées différemment selon le contexte professionnel. Cette divergence souligne l’importance de créer des passerelles entre disciplines pour que l’éthique journalistique prenne réellement en compte les implications des technologies d’IA.

7.

On parle souvent de l’importance d’intégrer les valeurs journalistiques directement dans les systèmes d’intelligence artificielle, comme si celles-ci pouvaient être traduites en règles techniques ou en paramètres algorithmiques. Cette idée repose toutefois sur une vision largement simplificatrice du fonctionnement des modèles d’IA, en particulier des grands modèles de langage. Ces systèmes ne disposent ni d’intentions, ni de jugement normatif : ils ne peuvent ni arbitrer entre intérêt public et sensationnalisme, ni évaluer la pertinence sociale d’une information.

Imaginer que des principes comme l’objectivité, la responsabilité ou la déontologie puissent être « encodés » dans des architectures statistiques revient à projeter des capacités humaines sur des outils qui n’opèrent que par calcul de probabilités.

Cette utopie masque un enjeu plus concret : les valeurs journalistiques ne se situent pas à l’intérieur des modèles, mais dans les choix humains qui encadrent leur conception et leur usage. Elles interviennent dans la sélection des données d’entraînement, dans la définition des objectifs assignés aux systèmes, dans les mécanismes de contrôle des sorties et, surtout, dans les décisions éditoriales finales. Plutôt que de chercher à moraliser les algorithmes, l’enjeu consiste donc à construire des dispositifs sociotechniques où l’IA reste un outil subordonné à des normes professionnelles clairement définies.

8.

Dans leurs pratiques quotidiennes, les journalistes utilisent des technologies d’intelligence artificielle souvent sans en être bien conscients, que ce soit via des correcteurs orthographiques, des outils de transcription ou de traduction. Ces usages, qui paraissent anodins, soulèvent pourtant des défis éthiques rarement questionnés, comme le respect de la confidentialité, la fidélité du contenu produit, ou l’influence involontaire sur la formulation et le sens des informations.

Avec l’essor des grands modèles de langage, on voit apparaître une nouvelle tendance : celle des moteurs de recherche augmentés, que l’on n’interroge plus par mots-clés mais par questions, dans un nouveau paradigme d’interaction humain-machine.

Ces nouveaux agents dits « épistémiques » ne renvoient plus une liste de liens, mais délivrent des réponses sous la forme de résumés. A l’instar des grands modèles de langage, ils ne sont pas conçus pour vérifier la fiabilité ou l’authenticité des sources et ne distinguent pas le vrai du faux. Sans doute de manière encore plus aiguë que pour les IA génératives, ils posent des questions centrales de confiance aveugle et de maintien de l’autorité humaine.

Que l’on pense à l’assistant IA de Google ou au moteur de recherche Perplexity, ces systèmes posent les mêmes problèmes épistémiques que les modèles de langage dont ils sont issus : hallucinations, bruits sémantiques, reproduction de biais culturels et sociaux, et risques de contenus manipulés.

De la même manière qu’ils peuvent produire de la mésinformation, c’est‑à‑dire des contenus incorrects générés sans intention de tromper et directement liés aux mécanismes probabilistes des modèles, ces technologies peuvent aussi être instrumentalisées pour diffuser de la désinformation, qui relève, elle, d’une volonté intentionnelle de manipuler les audiences.

9.

Il faut aussi rappeler que les IA génératives ne sont pas neutres. Derrière elles se trouvent des sociétés technologiques dont les choix de conception et de déploiement répondent souvent à des logiques commerciales, stratégiques, voire idéologiques.

Ces choix influencent directement les données utilisées pour entraîner les modèles, les paramètres d’optimisation retenus, les types de contenus privilégiés, ainsi que les mécanismes de filtrage et de sécurité intégrés. Autrement dit, les systèmes que nous utilisons portent l’empreinte des valeurs, priorités et arbitrages opérés par les acteurs qui les développent.

Les IA génératives sont également remplies de promesses qui ne sont pas toujours rencontrées.

Aux États-Unis, des études du MIT notamment ont montré que l’usage des IA génératives dans le secteur privé rencontre souvent des limites, avec une faible proportion de projets pilotes générant un impact financier significatif. De plus, la prolifération d' »AI slop » ou « workslop », qui font référence à des contenus de faible qualité produits par l’IA, a pour conséquence d’alourdir les charges de travail des employés, qui doivent trier, vérifier et corriger.

Pour les journalistes, cela ne veut pas dire un gain de temps mais du travail supplémentaire.

Aujourd’hui, le volume de contenus en ligne générés par l’IA dépasse celui produit par les humains, ce qui suscite naturellement la méfiance : ces contenus sont-ils complets, exacts, fiables ?

Dans cet environnement numérique, la surabondance d’informations va de pair avec une surabondance de désinformations, un phénomène amplifié par les réseaux sociaux, où les contenus polarisants et émotionnellement chargés sont favorisés par les logiques de l’économie de l’attention.

La vitesse et le volume croissants de contenus non fiables réduisent le temps disponible pour des vérifications approfondies, ce qui constitue un obstacle majeur aux pratiques journalistiques éthiques. Face à cette dynamique, l’IA joue un rôle paradoxal dans le travail de vérification car elle peut aider à repérer des schémas de désinformation ou à identifier des narratifs trompeurs. Dans le scénario idéal d’une approche hybride, largement adoptée par les organisations européennes de fact-checking, l’humain et la machine combinent leurs forces tandis que la responsabilité éditoriale demeure entièrement aux mains des journalistes.

10.

La déontologie journalistique, qui s’inscrit dans le cadre d’une éthique du devoir, repose sur des principes fondamentaux pour garantir la qualité et l’intégrité de l’information. Tous ces principes s’appliquent naturellement à l’usage des technologies d’IA dans les rédactions.

Toutefois, l’essor des IA générative a amené de nombreuses organisations médiatiques et professionnelles à publier, au cours de ces trois dernières années, une série de chartes, recommandations et prises de position. On dénombre au moins une cinquantaine de textes publics en Europe, et certains codes de déontologie nationaux, comme en Belgique flamande, au Royaume-Uni, en Italie, en Serbie ou en Slovénie, intègrent désormais des passages spécifiques sur l’IA.

Ces textes s’accordent sur des principes communs : reconnaître l’IA comme partie intégrante du processus éditorial, expérimenter de manière prudente et encadrée, assurer la transparence en divulguant les contenus générés et en précisant les conditions d’usage, maintenir l’équilibre et la diversité dans le traitement de l’information, et garder les humains dans la boucle afin de préserver le contrôle et la responsabilité éditoriale.

Cependant, ces chartes et recommandations présentent plusieurs limites. Elles restent souvent trop générales pour être appliquées efficacement face à l’évolution rapide des technologies, et certains points, comme l’explicabilité des systèmes ou l’évaluation pratique des outils, sont difficiles à mettre en œuvre dans la réalité des rédactions.

Les journalistes manquent souvent des compétences techniques pour participer pleinement au développement ou à l’audit des outils, et la simple transparence sur l’usage de l’IA ne suffit pas à corriger les biais algorithmiques, les erreurs dans les données d’entraînement, ni à éviter la production de résultats contenant des éléments de mésinformation ou de désinformation.

11.

A l’instar de toute norme sociale, les normes éthiques sont toujours le produit de négociations collectives et de rapports de force. Les technologies d’intelligence artificielle ne créent pas ces normes de toutes pièces. Elles les rendent plus visibles, plus explicites et plus réflexives.

C’est pourquoi il est essentiel d’enrichir l’éthique du devoir par une réflexion éthique fondée sur les conséquences des actions. Ici, l’enjeu n’est donc plus seulement de se conformer à des règles, mais de s’interroger sur la finalité et la portée sociale de l’usage des technologies d’IA dans les rédactions. Cette logique conséquentialiste, qui place l’évaluation des risques, des impacts et des bénéfices au centre du jugement moral, rejoint les préoccupations contemporaines portées par des instruments comme l’IA Act, l’instrument de régulation européen qui promeut une responsabilité partagée face à des technologies omniprésentes dans nos vies.

Le Conseil de déontologie journalistique et de médiation illustre concrètement cette orientation conséquentialiste : ses recommandations adoptent une approche centrée sur les risques liés à la qualité de l’information. On y distingue des usages à faible risque, comme la correction orthographique, qui ne nécessitent pas de divulgation, des usages à risque modéré, comme l’emploi de la traduction automatique, qui requièrent transparence et divulgation, et des usages à risque élevé qui sont prohibés, car ils concernent la génération de contenus pouvant tromper les audiences.

Si l’on se souvient de la photo de l’homme en colère présentée en introduction, il s’agissait d’une image générée par une IA représentant Steve Jobs, publiée par le site Jeuxvideo.com pour illustrer un article. Cette illustration, montrant le cofondateur d’Apple le visage déformé par la colère, a entraîné une saisine auprès du CDJM, a statué. Il a considéré que la publication d’un « faux » constitue une faute déontologique majeure, car elle ne respecte pas le principe de véracité et risque donc de tromper le public.

12.

L’utilisation d’images générées par l’IA pour illustrer un article constitue l’un des aspects des problèmes ou dérives éthiques pouvant se poser dans le journalisme. Un autre risque réside dans une confiance aveugle dans la technologie, qui peut entraîner un contrôle humain insuffisant.

L’an passé, l’agence de presse norvégienne a publié une dépêche issue d’un rapport d’une société de télécommunication scandinave, qui comportait des passages inventés et même le nom d’un responsable fictif. Cet incident est survenu parce qu’un journaliste avait utilisé un outil d’IA sans vérifier le contenu généré, violant directement les standards éditoriaux.

Mais les fautes professionnelles ne sont pas toujours celles imputables aux journalistes. En Belgique, l’éditeur Ventures Media a « embauché », si tant est que l’on puisse employer ce terme, deux journalistes pour les éditions néerlandophones et francophones de Elle Belgique. Nous voyons ici Sophie Vermeulen, un personnage inventé de toutes pièces, crédité de plus de 400 articles publiés au cours des trois derniers mois avant la révélation de l’affaire en juin 2025. Des profils de journalistes fictifs et des articles générés ont également été utilisé dans d’autres magazine de l’éditeur, dont Forbes et Marie-Claire.

L’éditeur s’est défendu, arguant de tests éditoriaux temporaires.

Ceci illustre bien les dérives d’une logique purement utilitariste où l’efficacité prime sur la transparence et l’honnêteté. Il renforce l’appel à une responsabilité éditoriale élargie, au-delà des seuls journalistes, et qui incluent management et directions.

13.

Car en définitive, il s’agit avant tout d’une question de confiance, un capital qui n’est pas au mieux de sa forme depuis plusieurs années. L’usage de l’IA, loin de restaurer cette confiance, risque au contraire de creuser la fracture : là où certaines entreprises de presse voient dans ces technologies une bouée de sauvetage face à une crise structurelle et persistante, elles peuvent également produire l’effet inverse.

Les recherches de l’institut Reuters pour l’étude du journalisme à l’université d’Oxford montrent que les audiences restent sceptiques vis-à-vis de l’information générée par l’IA et doutent de l’exactitude et de la fiabilité des contenus produits par des systèmes automatisés. Ce scepticisme varie selon le type d’usage : la correction orthographique et grammaticale est généralement bien acceptée, tandis que la génération de contenus rédactionnels rencontre une tolérance beaucoup plus faible, soulignant l’importance de maintenir une supervision humaine.

14.

Les règles fixent des repères indispensables, l’analyse des conséquences permet d’anticiper les risques et les impacts sociaux, et l’éthique de la vertu garantit un jugement responsable lorsque les cadres existants se révèlent insuffisants ou inadaptés.

Une réflexion éthique pleinement aboutie ne saurait faire l’économie de la troisième grande tradition philosophique de l’éthique : l’éthique de la vertu. Cette approche déplace le regard des seules règles ou conséquences vers les dispositions morales de l’agent.

Elle invite à s’interroger sur les qualités professionnelles et humaines du journaliste qui permettent d’exercer un jugement éthique dans des situations complexes, incertaines et souvent inédites, comme celles posées par l’intégration des technologies d’IA dans les processus éditoriaux.

Pour autant, l’éthique journalistique n’est pas plus mal en point qu’hier, mais elle est une nouvelle fois mise à l’épreuve.

Elle exige de réfléchir aux effets de mode, aux discours de disruption, ainsi qu’à toutes les grandes utopies et dystopies qui entourent l’intelligence artificielle. Ce nécessaire regard réflexif fait apparaître, une fois encore, l’importance critique de la littératie de l’IA.

Il est vrai que l’on confond souvent disruption, entendue comme une rupture radicale des structures et des pratiques, avec l’effet de nouveauté et le battage médiatique autour des IA génératives. La véritable « rupture » provient moins de la technologie elle‑même que des attentes démesurées que l’on peut projeter sur ces outils, souvent en décalage avec leurs capacités réelles.

Or, la cohérence institutionnelle du journalisme repose sur trois piliers : la vérification des faits, le jugement éditorial, et la responsabilité des auteurs, et ces piliers ne sont pas remis en question.

15.

Lorsque l’usage de l’IA dans le journalisme est présenté comme une adaptation inévitable à la complexité du monde contemporain, on peut y voir aussi une forme d’abdication. Une IA ne lit pas : elle structure, filtre et hiérarchise l’information selon des logiques qui ne sont ni neutres ni pleinement transparentes. Plutôt que d’interroger les contraintes économiques et organisationnelles qui rendent le journalisme de qualité parfois difficile à soutenir, on entérine ces contraintes.

Aussi, les débats autour de l’éthique de l’IA ne devraient pas occulter les crises profondes qui traversent le journalisme, en tant que profession, en tant qu’institution et en tant qu’organisation. Les technologies de l’IA peuvent contribuer à résoudre certains problèmes ponctuels, mais elles ne régleront pas la précarité du métier. Au contraire, elles risquent de l’accentuer. Elles ne vont pas non plus répondre aux défis structurels liés à la concentration des médias, la fragilisation des modèles économiques ou encore la perte de confiance des audiences.

L’IA peut fournir des outils et des aides opérationnelles, mais elle ne constitue en aucun cas une solution aux problèmes systémiques qui fragilisent le journalisme.

Le journalisme a toujours connu des tensions éthiques, nécessitant de trouver un équilibre entre idéaux du métier et contraintes professionnelles et organisationnelles. L’usage croissant des technologies d’intelligence artificielle dans les rédactions, couplé à un glissement d’une société de l’information vers une société de la désinformation, constitue un double défi majeur où se mêlent aspects technologiques, sociaux, économiques et épistémiques.

Ces enjeux ne remettent pas en cause les fondements de l’éthique journalistique : la recherche de la vérité, l’indépendance et la crédibilité restent au cœur du métier. En revanche, ils imposent de repenser le rôle et la place du journalisme face à un brouillage croissant entre la fiction et la réalité.

Comme je le concluais dans mon article publié l’an passé dans la revue I2D, le tandem IA et désinformation peut être envisagé comme offrant de nouvelles opportunités susceptibles de restaurer une relation de confiance avec les audiences : celle pour les journalistes, de se positionner en arbitre, hors de la mêlée, et celle de réaffirmer leur rôle en tant que repère fiable dans le brouillard (dés)informationnel.