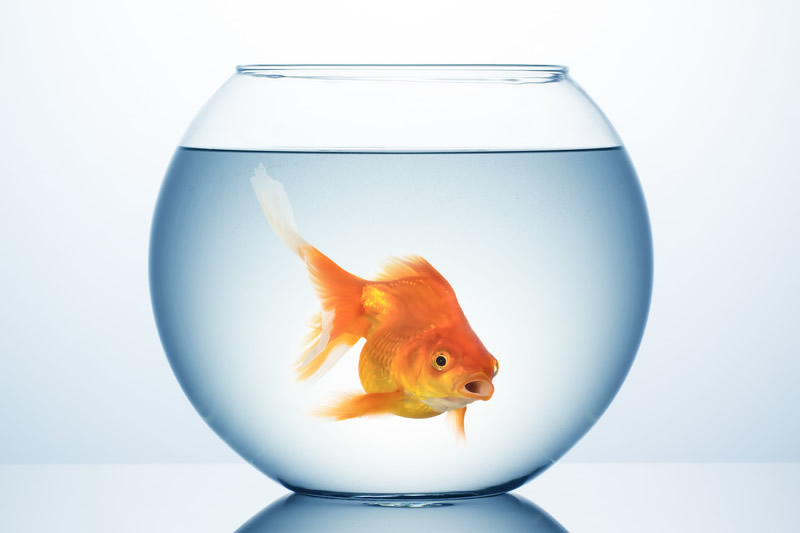

A l’image d’un poisson rouge, elles t’enferment dans ton bocal. Les « filter bubbles » ou « bulles de filtres » consistent à présenter des contenus ou résultats en fonction de son expérience de navigation en ligne. Leur objectif : créer des conditions optimales pour tailler sur mesure la diffusion de contenus. Ce premier volet consacré aux bulles de filtres explore le terrain des réseaux sociaux, des moteurs de recherche et des sites d’e-commerce.

Conçues à l’origine pour maximiser l’impact d’un message publicitaire en ciblant l’internaute à partir de ses préférences et choix, les bulles de filtres participent à une stratégie de segmentation des publics. S’ils posent les questions de l’exploitation des données à caractère personnel et des règles de protection de la vie privée, ces filtres s’inscrivent dans une logique algorithmique où la curation des données se trouve au cœur des protocoles sociaux (Wormser 2017) [1]. Le concept de « bulles de filtres » est décrit en 2011 par Eli Pariser, comme l’état dans lequel se trouve un internaute lorsque les informations affichées sur une page web résultent d’une personnalisation basée sur la collecte des données de cet internaute. La bulle est créée dès lors que chaque page web participant à ce système sera présentée de manière différente à chaque internaute [2].

Dans ta bulle, on te dit ce que tu peux voir…

Le contrôle des contenus s’affichant sur les pages personnelles des utilisateurs s’opère à partir de filtres, qui vont prendre en compte toute une série d’informations relatives à l’utilisateur : ce qu’il a aimé, ce qu’ont aimé ses amis, les pages web qu’il a visitées, les commentaires qu’il a déposés… Sur Facebook, une première conséquence de l’application de ces filtres consiste à empêcher ses utilisateurs d’accéder à des opinions politiques contradictoires [3]. Une deuxième conséquence porte sur l’anticipation des désirs de l’utilisateur, le système étant conçu pour prédire ce que l’utilisateur va aimer : pour Latzer (2015), le biais idéologique est évident. Et il n’est pas sans dangers en raison de sa potentialité à limiter la diversité des médias qui y sont exposés et, partant, de sa possible incidence sur le discours démocratique, l’ouverture d’esprit et un espace public « sain » (Borgesius & alli 2016). Ce type de personnalisation va également avoir tendance à isoler l’utilisateur au sein de sa communauté et à créer un « cocon d’informations » [4].

Bozdag & van den Hoven 2015 (2015) estiment qu’il s’agit d’une cyber-balkanisation, concept qui renvoie à l’idée d’une ségrégation d’internet en petits groupes politiques ayant des perspectives similaires : les bulles bloquent les canaux d’informations entrant et sortant [5]. Toutefois, il est encore difficile de déterminer les effets à long terme de cette personnalisation : sur le plan de la recherche empirique, il manque encore de preuves [4].

En Suisse, des étudiants en journalisme ont mené une expérience originale en créant de faux profils sur Facebook dans lesquels ils se sont glissés dans la peau d’un militant, dans le contexte des élections présidentielles françaises. Ses résultats démontrent « l’importance de la communauté : les publications des amis sont largement mises en valeur, et prennent l’ascendant sur le reste, comme l’a annoncé Facebook en 2016. Il y a un vrai sentiment d’appartenance à un groupe, et ce, au détriment des médias traditionnels qui perdent en visibilité, en impact et surtout en capacité de résonance« . Il a également été observé une polarisation dans les murs d’actualités de ces faux profils, en lien avec les idées du candidat suivi par chacun d’entre eux. « Pour autant, c’est plus les médias (et leur couleur politique) que les contenus eux-mêmes qui semblaient déterminants pour l’algorithme« .

…mais aussi ce que tu ne peux pas voir

Dans le sens inverse, les filtres d’exclusion visent « à censurer des messages engagés pour la liberté de pensé » [1]. Cette forme de censure n’est pas toujours facile à comprendre, alors que des images violentes d’ISIS (tortures, exécutions…) ont longtemps été diffusées librement sur les réseaux sociaux sans aucune forme d’interventionnisme. Elle l’est d’autant plus lorsqu’une image évoquant la nudité est censurée sur Facebook, alors que celle-ci ne rime pas forcément avec pornographie, à l’instar de cette photo de presse datant de la Guerre du Vietnam censurée parce qu’une fillette y apparaît dénudée parmi d’autres enfants ayant pris la fuite après un bombardement américain [1] . Google, dans le cadre de son programme de publicités AdSense, a récemment prié un média en ligne de supprimer un dessin de presse contrevenant à ses règles de bonne conduite (le dessin en question montrait un couple dans un lit, recouvert d’un drap suggérant mais ne montrant pas). Amazon a censuré « L’origine du monde » de Gustave Courbet, une toile peinte en 1866 et exposée au musée d’Orsay à Paris depuis 1995.

Les exemples sont légion et posent la question d’un formatage intellectuel en fonction de normes de bien-pensance en décalage avec une époque où, que ce soit pour vendre une voiture ou un pot de yaourt, les publicitaires n’hésitent pas à effeuiller la féminité. En Belgique flamande, même les autorités sont beaucoup moins complexées : en témoigne ce site internet où des textes et dessins explicites ont pour objectif d’enseigner la sexualité à des enfants de dix ans. Si l’affaire a pu choquer, le site reste toutefois très bien référencé : il arrive en tête des résultats de recherche sur Google, pour la requête « alles over seks » (« tout sur le sexe »).

Dans ta bulle, la transparence est une illusion

Les données personnelles d’un utilisateur deviennent alors un instrument d’anticipation des désirs. Si tu achètes un livre sur l’informatique chez Amazon, le géant américain s’empressera de t’en proposer des dizaines d’autres. Si tu fais ta petite étude de marché pour t’offrir une nouvelle télévision puis que tu te rends sur une page d’un site d’informations ayant souscrit au programme AdSense de Google, il y a plus que de fortes chances pour que la publicité qui apparaisse te propose de te rendre dans une boutique en ligne pour y acheter une télé ou bien de te laisser tenter par une offre triple play tv-internet-téléphone. Le procédé est juteux : les systèmes de recommandation auraient ainsi une plus grande influence sur les choix des utilisateurs que les pairs et les experts (Nguyen & alli 2014) [6]. Cette opinion ne fait pas l’unanimité, d’aucuns considérant que les systèmes de recommandations augmentent la sérendipité.

Il n’y a rien de nouveau là-dedans, et rien de bien opaque non plus, si l’on en croit les plateformes faisant usage de filtres. Google va même proposer une « aide » à la personnalisation d’annonces. « Les annonces diffusées par Google sont personnalisées en fonction de nombreux facteurs, tels que les types de sites Web que vous visitez ou les applications mobiles que vous avez installées. Voici certains des nombreux facteurs pris en compte par Google pour vous présenter des annonces : les types de sites Web que vous consultez et les applications installées sur votre appareil, les cookies installés dans votre navigateur et les paramètres de votre compte Google, les sites Web et les applications que vous avez consultés appartenant à des entreprises qui diffusent des annonces avec Google, votre activité sur un autre appareil, les interactions antérieures avec des annonces ou des services publicitaires de Google, votre activité sur le compte Google et les informations le concernant« . Même ta boîte e-mail ne va pas y échapper. Mais on te l’explique, au moins tu es prévenu (à condition de chercher un peu pour trouver l’information) .

Chez Microsoft, on explique que la personnalisation permet de mieux informer, tout ça grâce aux cookies qui sont déposés dans l’ordinateur de l’utilisateur et à son insu. « Représentez-vous un cookie comme une carte d’identification qui est uniquement la vôtre. Son travail est d’indiquer au site lorsque vous y retournez. Bien qu’il soit possible d’en faire une mauvaise utilisation dans des cas où ils renferment des données personnelles, les cookies ne sont pas par eux-mêmes malveillants. La plupart des sites Web, y compris Microsoft, utilisent des cookies. Les cookies nous indiquent la fréquentation des pages que vous visitez, ce qui nous aide à connaître les informations qui vous intéressent. Ainsi, nous pouvons vous donner plus de contenu qui vous intéresse et moins de contenu qui ne vous intéresse pas« .

De même, Facebook ne cache pas qu’il s’inscrit dans une logique de personnalisation de contenus et annonces. Il demande même à ses utilisateurs de l’y aider, en acceptant les cookies permettant de collecter les informations de l’utilisateur. Mais en amont, il est impossible de savoir quels processus sont à l’œuvre et, surtout, quelles sont les choix humains qui les ont sous-tendus. La transparence n’est donc qu’apparente.

Pour Diakopoulos (2015) [7], il s’agit d’un terrain que les journalistes devraient investiguer mais il convient de ne pas oublier que n’importe quelle procédure informatique ne fait jamais que traduire des intentions humaines décidées en amont. Peut-être que la transparence devrait davantage venir de ce côté plutôt que celui du code informatique, qui suppose des compétences spécifiques pour pourvoir être compris (Burrell 2016) [8]. « Bien qu’utiles, les filtres de personnalisation – qu’ils soient algorithmiques, sociaux ou combinés – comportent des biais qui affectent notre accès à l’information de manière importante », soulignent Nikolov & alli (2015) [9]. Enfermer un internaute dans son propre univers, c’est créer les conditions d’une monoculture dangereuse pour l’exercice citoyen du sens critique.

Sortir de ta bulle

Ces différents mécanismes ne font pas l’objet d’un choix librement consenti, c’est là leur caractéristique commune. De plus en plus de sites web affichent un message du type « ce site utilise des cookies, cliquez ici pour accepter » mais, dans la plupart des cas, ils ne donnent pas la possibilité de les refuser. Il existe quelques moyens pour les contourner, en utilisant un bloqueur de pub par exemple, un outil à double tranchant car les sites d’information dont le modèle économique repose sur la seule publicité risquent de ne pas permettre l’accès à leurs contenus… à moins de désactiver l’outil. Une autre technique consiste dans le nettoyage régulier des cookies, soit via le navigateur web que l’on utilise régulièrement, soit via un logiciel tel que CCleaner, néanmoins récemment victime d’un virus informatique. Il est également possible de limiter les risques d’exposition en privilégiant un navigateur open source comme Firefox, ou un moteur de recherche revendiquant ne pas collecter les données personnelles de ses utilisateurs comme le fait Duck Duck Go. L’extension pour Chrome EscapeYourBubble a pour objectif de décloisonner l’expérience de l’utilisateur de Facebook, en insérant dans son fil d’actus des contenus qui « défient sa vision du monde et encourage à mieux connaître l’autre partie ». Une autre possibilité est d’adopter le mode « navigation privée » ou de modifier son adresse IP à chaque nouvelle connexion mais cela va ralentir de manière plus ou moins considérable le temps de chargement des pages. Une dernière solution, bien plus radicale, consisterait à devenir technologiquement moins dépendant.

Images : CanStockPhotos

+ Lire le long format : La personnalisation « as a service »

+ Lire le long format : Les algorithmes dans l’information

Références

[1] Wormser, G. (2017). Building Global Community : La tentation hégémonique de Mark Zuckerberg et de Facebook. Sens Public.

[2] Pariser, E. (2011). The filter bubble: What the Internet is hiding from you. Penguin UK.

[3] Lazer, D. (2015). The rise of the social algorithm. Science, 348(6239), 1090-1091.

[4] Zuiderveen Borgesius, F., Trilling, D., Möller, J., Bodó, B., de Vreese, C., & Helberger, N. (2016). Should we worry about filter bubbles. Internet Policy Review, 5(1), 2.

[5] Bozdag, E., & van den Hoven, J. (2015). Breaking the filter bubble: democracy and design. Ethics and Information Technology, 17(4), 249-265.

[6] Nguyen, T. T., Hui, P. M., Harper, F. M., Terveen, L., & Konstan, J. A. (2014, April). Exploring the filter bubble: the effect of using recommender systems on content diversity. In Proceedings of the 23rd international conference on World wide web (pp. 677-686). ACM.

[7] Diakopoulos, N. (2015). Algorithmic accountability: Journalistic investigation of computational power structures. Digital Journalism, 3(3), 398-415.

[8] Burrell, J. (2016). How the machine ‘thinks’: Understanding opacity in machine learning algorithms. Big Data & Society, 3(1).

[9] Nikolov, D., Oliveira, D. F., Flammini, A., & Menczer, F. (2015). Measuring online social bubbles. PeerJ Computer Science, 1, e38.