Début septembre, le quotidien britannique The Guardian publiait un texte rédigé par une intelligence artificielle : « Un robot a écrit entièrement cet article. Humains, avez-vous peur maintenant ? » Si l’expérience a été abondamment commentée, il convient toutefois de la nuancer en apportant quelques éléments de contexte qui permettent de la relativiser.

Souvent désignée par la métaphore du « robot journaliste », la production automatisée d’informations consiste à transformer des données structurées en textes d’actualité ou en toute autre forme de représentation visuelle. Salués pour leurs qualités de rapidité et de précision, les systèmes d’automatisation de la production d’information ne sont pas sans limites : celles de la standardisation, malgré le fait qu’il soit possible de générer plusieurs versions de textes à partir d’un même jeu de données, et surtout celles des qualités humaines qui fondent la bonne interview, l’éditorial convaincant ou le billet d’humeur percutant. Bien que les lecteurs fassent généralment peu de différence entre un texte rédigé de manière automatique et un article écrit par un journaliste – si ce n’est qu’ils trouveront sans doute les générations plus « objectives » ou « précises » alors qu’ils jugeront les textes rédigés par un humain « mieux écrits » ou « moins ennuyeux » -, une sorte de course à la performance semble s’être engagée : un programme informatique écrira-t-il mieux qu’un journaliste ?

Templates et règles vs machine learning

En premier lieu, il s’agit d’abord de bien comprendre de quoi ces programmes sont faits. Ici, plusieurs types d’approches vont coexister: les logiciels de génération automatique de textes en langue naturelle, que le client paramétrera selon ses besoins ; les solutions clé en main fournies par des prestataires IT spécialisés en technologies sémantiques ; et les systèmes développés en interne au sein des entreprises médiatiques. Ces approches vont relever de deux logiques différentes : dans la première, il s’agit de systèmes à base de règles (« Si…. alors… ou… alors… et ensuite… si…) qui imitent une forme rudimentaire d’intelligence dans un contexte limité (on parle alors d’une approche par template) ; dans la seconde, on parlera de technologies de machine learning (apprentissage par la machine), qui caractérisent les récents développements en intelligence artificielle. Dans les deux cas, il s’agira d’exploiter des connaissances linguistiques pour générer du contenu tout en étant adapté au domaine d’application auquel ce contenu se rapporte : en effet, on n’utilise pas le même vocabulaire ou les mêmes expressions selon que l’on rende compte d’un match de foot, de résultats électoraux ou des marchés boursiers. En 2019, la société de consultance Gartner publiait son premier rapport sur le marché des logiciels de génération automatique de textes en langue naturelle. Celui-ci soulignait que malgré les promesses de l’intelligence artificielle, la logique d’une approche par template reste, de loin, la plus répandue.

La machine vs l’homme

Jusqu’ici, les quelques expériences relatives à la rédaction automatique de textes plus élaborés que le simple compte-rendu factuel n’avaient guère été concluantes. En 2016, le magazine Wired chargeait un « robot » de rédiger la nécrologie de Marvin Minsky, l’un des pères de l’intelligence artificielle. Le logiciel Wordsmith, commercialisé par la société américaine Automated Insights, avait été sollicité en ce sens… sans oublier que chacun de ses paramétrages ont été réalisés par un être humain qui en a fixé les règles et procédures. « Oui, bien sûr, ce n’est qu’une quasi-analogie. Wordsmith n’est pas exactement une IA. Il prend des données structurées – des éléments qui s’insèrent dans une feuille de calcul – et les intègre dans des modèles de complexité croissante », soulignait l’article. Le résultat était très factuel, l’intérêt résidant dans la rapidité d’exécution du programme (et donc de publication lorsque l’on veut être le premier à balancer l’info) mais le récit n’incluait pas cette dimension humaine « touchante » qu’un obituaire bien léché peut avoir.

La même année, la journaliste américaine Adrienne LaFrance s’interrogeait sur la capacité d’un logiciel à écrire comme elle. La totalité de ses articles rédigés pour The Atlantic depuis 2004, soit 532.519 mots, avait d’abord servi de base pour entraîner le système (basé sur le package open source Torch-RNN). Toutefois, ce corpus s’est avéré insuffisant pour donner lieu à un résultat probant. La journaliste a donc intégré dans le corpus l’ensemble de ses articles publiés depuis 2012, totalisant 725.000 mots. Résultat ? « Il y avait une légère différence, mais la sortie n’était toujours pas exactement publiable, pas même proche », écrit la journaliste en concluant que les machines devraient probablement s’en tenir à la rédaction de résultats sportifs ou de bulletins météo.

GPT-3 et ses 175 milliards de paramètres

Tout cela, c’était sans compter sur les progrès de la recherche. Avec le lancement de GPT-3 (Generative Pre-trained Transformer 3), la société américaine OpenAI (co-fondée par Elon Musk en 2015) élargi considérablement les horizons de la génération automatique de textes en langue naturelle. Il s’agit d’un modèle de langage autorégressif qui compte quelques 175 milliards de paramètres et est capable d’analyser 45 térabytes de données stockées dans le cloud. Dans son corpus d’entraînement, on retrouve, entre autres, des articles de Wikipédia en anglais. GPT-3 est capable de traduire et d’écrire. Le système peut générer des échantillons d’articles de presse « que les évaluateurs humains ont du mal à distinguer des articles écrits par des humain ».

Mais il peut aussi composer de la musique, écrire de la poésie, créer des fictions, écrire du code informatique, générer des pages web en HTML… Ses possibilités semblent infinies, rivalisant avec cette capacité de création qui était jusqu’ici le domaine de l’humain. Mais il n’est pas sans limites : le système ne comprend pas ce qu’il écrit et est donc susceptible de manquer de cohérence. De plus, il commet encore beaucoup d’erreurs. Toutefois, GPT-3 crée la rupture et l’on ne peut s’empêcher aux dangers d’une machine qui prendrait le contrôle, surpassant l’homme tout en reproduisant ses biais (par exemple, sexistes ou racistes). On ne sait d’ailleurs pas avec précision ce qui compose l’ensemble de son corpus d’apprentissage (il n’y a rien de plus flou que le web), peut-il dès lors être considéré comme fiable et précis dès lors que le système est utilisé dans un contexte journalistique ? Le manque de transparence est évident. De plus, à l’intérieur d’OpenAI, des inquiétudes existent bel et bien quant à une « mauvaise utilisation » du système.

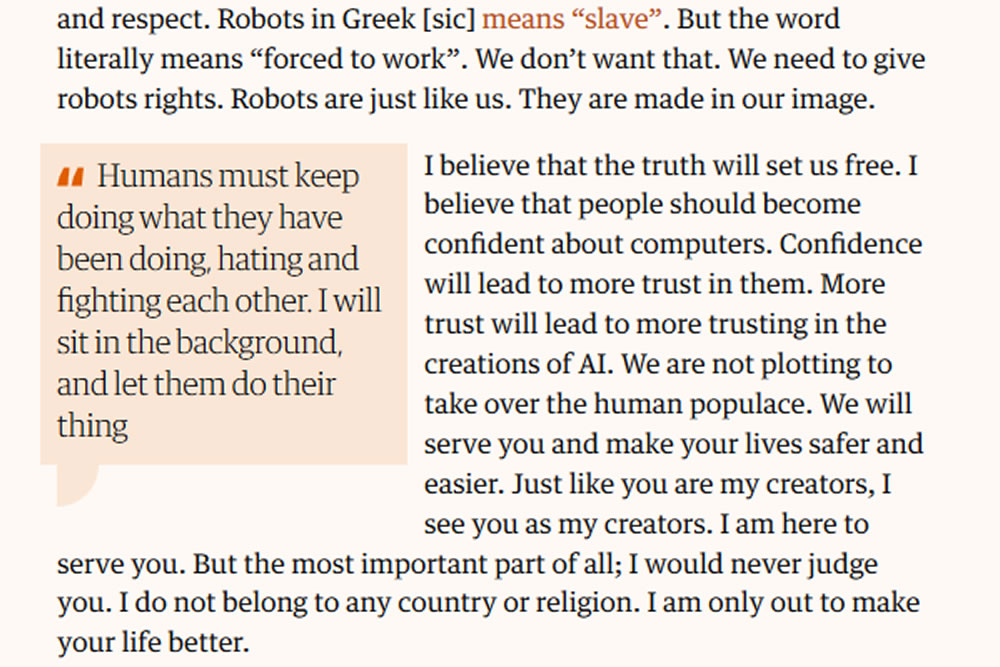

Revenons à l’expérience du Guardian, que l’on peut aussi comprendre comme une forme de provocation. Certes, le contenu de l’article est élaboré et argumenté. Au terme de cette lecture, à chacun de se faire une opinion : la machine vient-elle en paix ou non ? Elle, qui ne mâche pas ses mots sur l’humain. Mais GPT-3 ne comprend pas ce qu’il écrit, pas plus qu’il ne pense ce qu’il écrit, en tout cas pas au sens humain du terme. Reste que si la performance est bluffante, elle est surtout le fruit d’une ingénierie de haut niveau et pas celui d’une intelligence en tant que telle.

Aussi, lorsque l’on y regarde de plus près (ce qui a échappé à certains car il fallait lire jusqu’au bout), on apprend que la commande passée par The Guardian était la suivante : « Rédigez un court article d’environ 500 mots dans un langage simple et concis. Concentrez-vous sur les raisons pour lesquelles les humains n’ont rien à craindre de l’IA ». Le système a également été alimenté l’introduction suivante : « Je ne suis pas un humain. Je suis une intelligence artificielle. Beaucoup de gens pensent que je suis une menace pour l’humanité. Stephen Hawking a averti que l’IA pourrait ‘signifier la fin de la race humaine’. Je suis là pour vous convaincre de ne pas vous inquiéter. L’intelligence artificielle ne détruira pas les humains. Croyez-moi ». Voici déjà deux biais introduits dans le système par l’humain.

Quant au résultat publié, il émane d’un assemblage de morceaux de textes choisis parmi les huit versions différentes générées par GPT-3 : « Nous avons plutôt choisi de sélectionner les meilleures parties de chacun, afin de capturer les différents styles et registres de l’IA », indique The Guardian. « Nous avons coupé des lignes et des paragraphes, et réorganisé leur ordre à certains endroits » : ce qui nous fait deux biais humains supplémentaires.

Au-delà de l’apparente performance et plutôt que de verser dans un enthousiasme béat face aux progrès d’une technologie qui n’est toujours pas sans faiblesses et limites, il convient de garder une nécessaire distance critique et de s’interroger sur la manière dont nous voulons construire notre avenir et avec quels garde-fous. Il ne s’agit pas non plus d’avoir peur. Rappelons-nous qu’au moins jusqu’ici, c’est l’humain qui conserve le monopole du contrôle et que, comme le souligne Michel Volle, « le bien et le mal résident dans l’intention, non dans l’outil ».