Ils ne peuvent pas être considérés comme fiables, exacts et sans biais, mais les journalistes expérimentent quotidiennement les grands modèles linguistiques (LLMs). S’ils peuvent être perçus comme ouvrant de nouvelles perspectives pour soutenir le processus journalistiques et éditorial, leurs usages ne sont pas sans risques. Une approche prudente envisage donc les LLMs comme des outils d’assistance qui ne peuvent se substituer au travail journalistique humain, nécessitant une attention particulière pour garantir la qualité de l’information.

Aide à la découverte d’histoires, à l’exploration de documents et à la recherche préliminaire

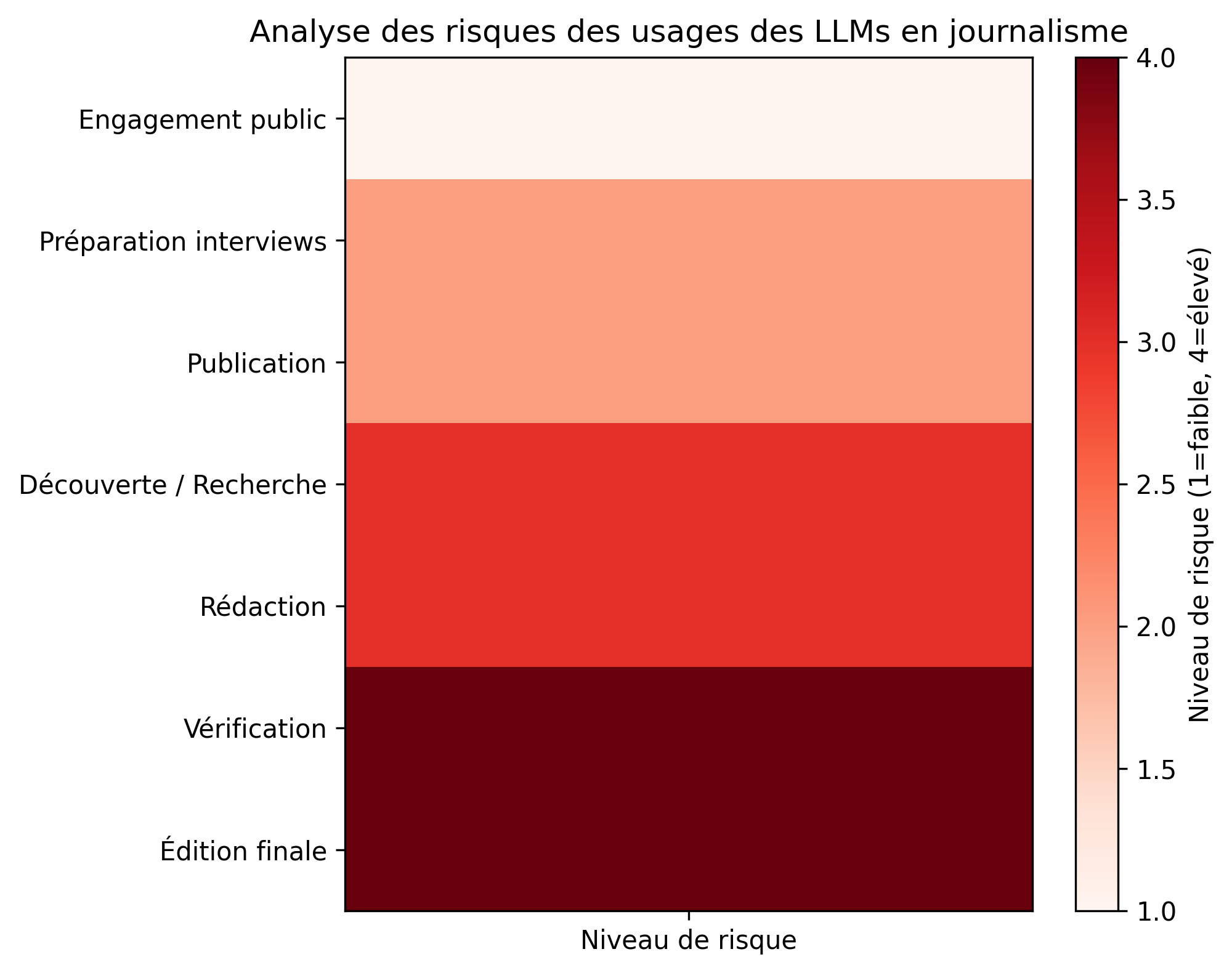

Niveau de risque : modéré à élevé

Les LLMs peuvent aider les journalistes à parcourir les sources d’information, les forums, les bases de données et les réseaux sociaux à la recherche de sujets émergents. Ils facilitent l’exploration de grands ensembles de documents en extrayant des entités, en détectant des modèles et en résumant le contenu, ce qui rend l’exploration et l’analyse préliminaire plus accessibles. Cependant, les risques sont ici importants. Les LLM ne « comprennent » pas les informations ; ils identifient plutôt des modèles de manière statistique, ce qui signifie qu’ils peuvent passer à côté d’informations essentielles, négliger des contradictions ou mettre en évidence des tendances superficielles. Des pistes d’enquête complexes pourraient être ignorées. Une dépendance excessive aux LLMs peut appauvrir les récits, introduire des biais ou conduire à des interprétations superficielles sans approche critique des sources.

Recherche et préparation d’interviews

Niveau de risque : faible à modéré

Les LLMs peuvent aider à réfléchir à des perspectives plus larges, notamment en compilant des notes, en suggérant des contacts avec des experts, en anticipant les questions d’interview ou en simulant des dialogues potentiels. Les principaux risques concernent les suggestions de questions obsolètes, incomplètes ou biaisées. De plus, comme les LLMs se contentent de reproduire des modèles plutôt que de générer des idées originales, ils doivent être considérés comme un instrument destiné à stimuler la créativité plutôt que comme une source d’idées novatrices. D’un point de vue plus pratique, l’utilisation des LLMs avec des informations sensibles ou confidentielles n’est pas recommandée pour des raisons de sécurité.

Rédaction et amélioration de l’écriture

Niveau de risque : modéré à élevé

Les LLMs peuvent aident à structurer des premiers jets d’article, à suggérer des titres et à explorer différentes variations stylistiques. Ils peuvent proposer rapidement plusieurs approches narratives, aidant ainsi les journalistes à passer plus rapidement de l’idée au contenu écrit. Cependant, le risque d’« hallucination » et autres bruits sémantiques — la fabrication non intentionnelle de contenus ne reposant sur aucun fait vérifié ou l’addition de contenus trompeurs — est un problème persistant. Les résultats générés par l’IA peuvent également refléter des préjugés, privilégier certains cadres de référence par rapport à d’autres ou ne pas offrir un récit équilibré. Déléguer un tâche rédactionnelle à un LLM, c’est prendre le risque de ne pas garantir l’exactitude des faits, la cohérence et l’intégrité stylistique, à moins d’une supervision et validation humaine.

Vérification et édition

Niveau de risque : élevé

S’ils peuvent suggérer des pistes de clarification, repérer des incohérences ou identifier des éléments à vérifier, les LLMs ne peuvent en aucun cas être considérés comme des vérificateurs fiables. Ils ont tendance à inventer des citations, à déformer des faits ou à altérer subtilement le contexte des informations. Toute affirmation factuelle doit donc faire l’objet d’une vérification indépendante, à partir de sources primaires, de références fiables ou de témoignages directs. Dans ce cadre, la supervision éditoriale demeure indispensable. Loin de toujours faire gagner du temps, l’usage des LLMs peut même générer un surcroît de travail : les contenus produits à des fins de fact-checking nécessitent fréquemment un examen approfondi et des corrections supplémentaires. S’ils peuvent contribuer à l’évaluation des éléments recueillis, ils ne remplacent en aucun cas une vérification rigoureuse.

Edition finale, vérification linguistique

Niveau de risque : élevé

Les LLMs peuvent faciliter la révision et l’édition finale en vérifiant la grammaire, la ponctuation et le style. Toutefois, ils ont du mal à appréhender les aspects plus nuancés de la langue, en particulier lorsque le contexte est essentiel. Ils ne parviennent souvent pas à saisir pleinement la polysémie (mots ayant plusieurs significations) ou les homonymes (mots identiques mais ayant des significations différentes), ce qui peut entraîner des interprétations erronées ou des ambiguïtés. Leur manque de compréhension contextuelle signifie qu’ils peuvent passer à côté de la manière dont certaines expressions, idiomes ou terminologies spécifiques doivent être utilisés dans un contexte journalistique particulier. La révision humaine est donc indispensable pour s’assurer que le sens initial n’a pas été altéré et pour prévenir les erreurs susceptibles d’entraîner une confusion ou une mauvaise interprétation de l’article.

Publication et distribution

Niveau de risque : faible à modéré

Les LLMs peuvent aider à optimiser le contenu pour le référencement, à générer des titres accrocheurs, à créer des publications sur les réseaux sociaux et à rédiger des méta-descriptions, maximisant ainsi la portée et la visibilité des articles. Ici, les risques sont moindres, mais ils existent toujours, car les LLMs peuvent involontairement favoriser le sensationnalisme, les tactiques de clickbait, déformer le contexte d’un article ou créer du contenu inadéquat/halluciné. Par conséquent, une supervision éditoriale humaine est nécessaire pour garantir que les supports promotionnels restent fidèles à l’intégrité de l’article, en évitant les formulations trompeuses.

Engagement du public et analyse des commentaires

Niveau de risque : faible

Les LLMs peuvent résumer les commentaires des lecteurs, détecter les réactions émergentes et suggérer des sujets de suivi. Cela peut permettre aux journalistes de surveiller le sentiment du public sans avoir à passer au crible manuellement de grands volumes de commentaires. Cependant, une mauvaise interprétation par l’IA du sarcasme, de l’ironie ou du langage polarisé peut conduire à une évaluation erronée du sentiment du public. Ainsi, si les informations générées par l’IA peuvent être utiles, elles doivent être considérées comme des indications plutôt que comme des réponses définitives, les résultats générés devant donc être interprétés et exploités avec prudence.

| Étape du processus | Niveau | Réduction des risques |

|---|---|---|

| Découverte d’histoires et recherche préliminaire | Modéré à élevé | – Vérification critique des informations – Croisement et diversification des sources – Considérer l’IA comme un point de départ |

| Préparation et recherche d’interviews | Faible à modéré | – Vérifier l’actualité et la pertinence des questions – Reformulation humaine pour éviter les biais et stéréotypes – Ne pas utiliser de données sensibles/confidentielles |

| Rédaction et amélioration de l’écriture | Modéré à élevé | – Supervision éditoriale systématique – Vérification des faits – Réécriture humaine pour maintenir une cohérence stylistique et narrative |

| Vérification et édition (fact-checking) | Élevé | – Confirmer chaque élément auprès de sources primaires fiables – Ne pas considérer le LLM comme un vérificateur autonome – Supervision humaine indispensable |

| Édition finale et vérification linguistique | Élevé | – Relecture humaine pour garantir le sens et la nuance – Contrôle des ambiguïtés (homonymes, polysémie, idiomes) – Validation de la cohérence et de l’intégrité stylistique |

| Publication et distribution | Faible à modéré | – Vérifier la fidélité du contenu promotionnel – Contrôle des titres, accroches, méta-descriptions pour éviter sensationnalisme et clickbait – Supervision humaine pour garantir l’intégrité éditoriale |

| Engagement du public et analyse des commentaires | Faible | – Interprétation prudente des analyses de sentiment – Relecture humaine pour détecter le sarcasme ou l’ironie – Utilisation des résultats en tant qu’indications, pas comme des vérités définitives |

Références

- Augenstein, I., Baldwin, T., Cha, M., Chakraborty, T., Ciampaglia, G. L., Corney, D., … & Zagni, G. (2024). Factuality challenges in the era of large language models and opportunities for fact-checking. Nature Machine Intelligence, 1-12.

- Barrow, N. (2024). Anthropomorphism and AI hype. AI and Ethics, 1-5.

- Bender, E. M., Gebru, T., McMillan-Major, A., & Shmitchell, S. (2021, March). On the dangers of stochastic parrots: Can language models be too big?🦜. In Proceedings of the 2021 ACM conference on fairness, accountability, and transparency (pp. 610-623).

- Dierickx, L. (2025). Journalisme et devoir de vérité à l’épreuve de la désinformation et des contenus générés. I2D-Information, données & documents, (1), 31-38.

- Dierickx, L. (2025). Le fait émergent, ou (re)penser ce qui fait le fait. In Bienvenue en post-réalité. Meta-Media Cahier de Tendances de France Télévisions.

- Dierickx, L., Van Dalen, A., Opdahl, A. L., & Lindén, C. G. (2024). Striking the balance in using LLMs for fact-checking: A narrative literature review. In Multidisciplinary International Symposium on Disinformation in Open Online Media (pp. 1-15). Cham: Springer Nature Switzerland.

- Dierickx, L., Lindén, C. G., & Opdahl, A. L. (2023). The information disorder level (IDL) index: a human-based metric to assess the factuality of machine-generated content. In Multidisciplinary international symposium on disinformation in open online media (pp. 60-71). Cham: Springer Nature Switzerland.

- Floridi, L. (2024). Hypersuasion–On AI’s persuasive power and how to deal with it. Philosophy & Technology.

- Floridi, L. (2024). Why the AI Hype is Another Tech Bubble. Philosophy & Technology, 37(4).

- Helal, M. Y., Elgendy, I. A., Albashrawi, M. A., Dwivedi, Y. K., Al-Ahmadi, M. S., & Jeon, I. (2025). The impact of generative AI on critical thinking skills: a systematic review, conceptual framework and future research directions. Information Discovery and Delivery.

- Hicks, M. T., Humphries, J., & Slater, J. (2024). ChatGPT is bullshit. Ethics and Information Technology, 26(2), 38.

- Leaver, T., & Srdarov, S. (2023). ChatGPT Isn’t Magic: The Hype and Hypocrisy of Generative Artificial Intelligence (AI) Rhetoric. M/C Journal, 26(5).

- Malmqvist, L. (2025, June). Sycophancy in large language models: Causes and mitigations. In Intelligent Computing-Proceedings of the Computing Conference (pp. 61-74). Cham: Springer Nature Switzerland.

- Placani, A. (2024). Anthropomorphism in AI: hype and fallacy. AI and Ethics, 1-8.

- Runco, M. A. (2023). AI can only produce artificial creativity. Journal of Creativity, 33(3), 100063.