Invitée dans le cadre du cours d’analyse critique des médias de la professeure Florence Le Cam à l’ULB (Bac 1), j’ai eu l’occasion de parler de l’intelligence artificielle dans le journalisme, en explorant ses promesses et ses risques, son potentiel et ses dérives. Deux questions d’une étudiante en communication me sont parvenues à l’issue de cette séance. Elles ouvrent des perspectives plus larges sur l’impact de ces technologies sur nos démocraties et sur le contrôle de l’information.

Est-ce que les intelligences artificielles pourraient, dans un futur proche, transformer des pays (voire le monde ?) en un 1984 généralisé, en affaiblissant nos esprits critiques notamment, avec un (ou des) Big Brother observant continuellement nos faits et gestes ?

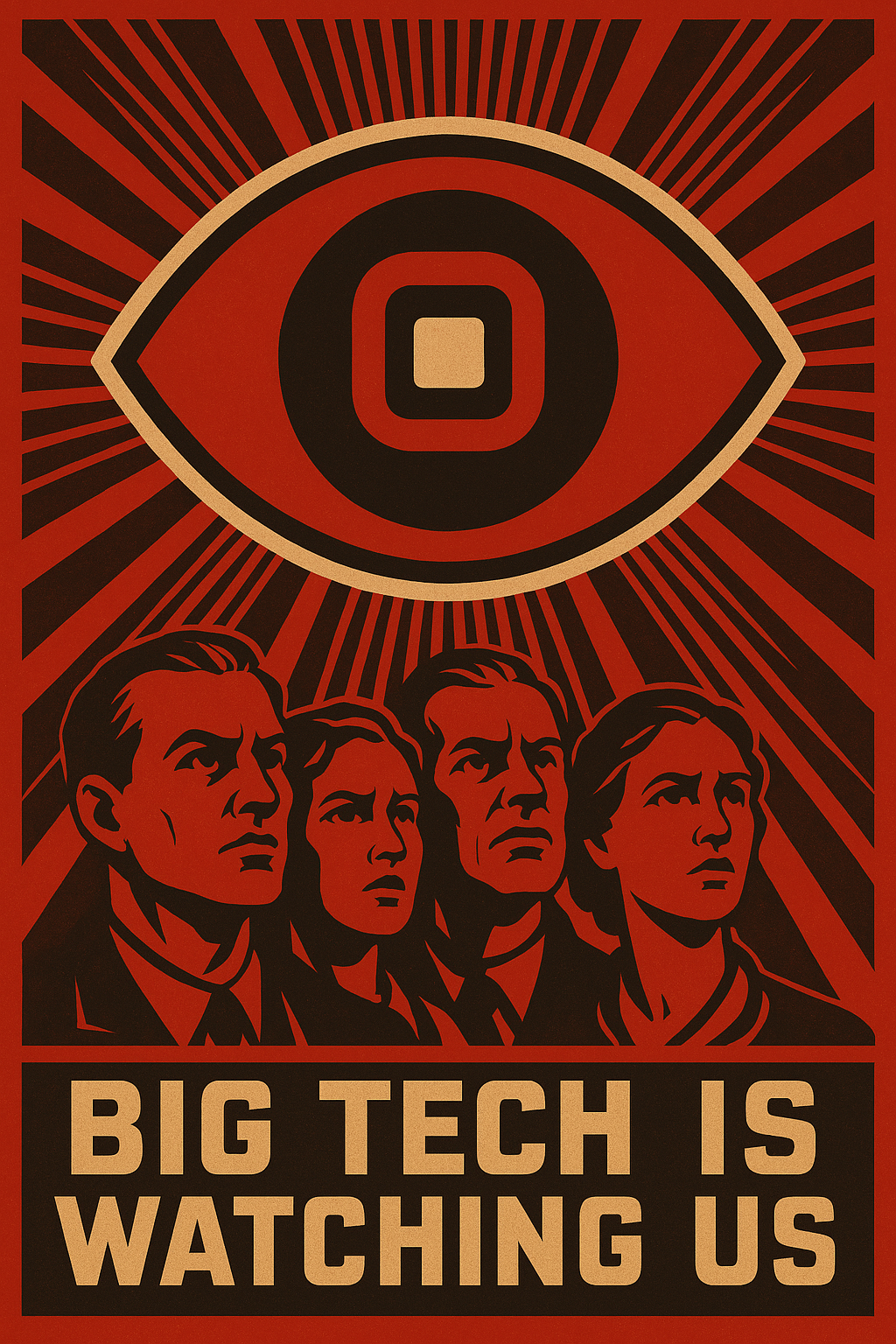

Les romans d’anticipation jouent un rôle important dans nos représentations des technologies de l’intelligence artificielle. Si l’on prend 1984 de Georges Orwell, nous nous trouverions dans une société sous l’emprise d’un pouvoir totalitaire (celui de la technologie) où la surveillance est omniprésente et la manipulation systématique. Dans ce cas de figure, le contrôle est basé sur la peur et la répression. A l’inverse, dans Le meilleur des mondes d’Aldous Huxley, le contrôle est plus insidieux car il opère dans une société du divertissement et de la satisfaction immédiate, où les personnes sont conditionnées à accepter leur sort grâce aux plaisirs artificiels. Une autre dystopie est celle imaginée par Philip K. Dick dans Les Androïdes rêvent-ils de moutons électriques ? où les frontières entre l’humain et la machine sont devenues indiscernables. Ces trois visions se reflètent à différentes échelles dans notre société actuelle : la difficulté croissante de distinguer un contenu généré par une IA, l’omniprésence du divertissement à travers les plateformes et les univers virtuels, ainsi que la surveillance constante, subtile mais omniprésente, derrière nos écrans.

L’idée d’un « 1984 généralisé » sous l’effet de l’intelligence artificielle, est donc déjà en partie une réalité. Les dispositifs de surveillance pilotés par l’IA, qu’ils soient justifiés par des impératifs de sécurité ou motivés par des intérêts économiques et politiques, se sont multipliés. À Paris, par exemple, la mise en place de caméras intelligentes pour les Jeux Olympiques illustre cette tendance où la surveillance est utilisée au nom d’une menace qu’il s’agit de prévenir. En ligne, nos échanges numériques ne sont pas toujours sécurisés. Bien que de nombreux service utilisent des mécanisme de cryptage, les messages peuvent être interceptés à différents points du réseau. C’est pourquoi envoyer une copie de sa carte d’identité par e-mail comporte des risques importants, notamment en matière de vol d’identité et de fraude.

Le logiciel espion Pegasus est l’exemple le plus marquant de l’utilisation des technologies de surveillance pour cibler des individus. Développé par l’entreprise israélienne NSO Group, Pegasus permet d’infecter les smartphones pour en prendre le contrôle. Ce logiciel a été utilisé par plusieurs gouvernements pour surveiller des journalistes, des opposants politiques et des défenseurs des droits humains, dans le but de collecter des informations sensibles ou de faire taire des voix dissidentes.

Dans ce contexte, la surveillance numérique n’est plus seulement une question de sécurité, mais un enjeu politique et démocratique majeur. Si des outils existent pour limiter l’emprise de ces mécanismes (cryptage des communications, protection des données, législation sur la vie privée), leur mise en place est souvent inégale et limitée face aux intérêts en jeu.

Nos activités en ligne ne sont pas seulement surveillées, elles sont aussi monétisées. Chaque site web visité, chaque recherche effectuée, chaque interaction sur les réseaux sociaux est collectée et analysée. Nos comportements numériques sont scrutés par des algorithmes prédictifs qui influencent ce que nous voyons, ce que nous achetons et même ce que nous pensons. Les entreprises du big tech américain telles que Google, Facebook, Amazon, Microsoft ou Apple, détiennent une quantité impressionnante de données sur chacun de nous et elles collectent en permanence des informations sur nos comportements, préférences, interactions et même nos émotions, via nos recherches en ligne, nos achats, nos interactions sur les réseaux sociaux et nos usages des appareils connectés. Ce profilage massif nous permet d’être constamment exposés à des publicités ciblées et des recommandations personnalisées, mais va bien au-delà. Ces entreprises accumulent une quantité de données personnelles qui leur permet de prédire nos actions futures et d’influencer nos choix, y compris politiques.

C’est le capitalisme de la surveillance nourri par une stratégie d’économie de l’attention, l’objectif étant de nous retenir captif le plus de temps possible pour générer un maximum de revenus. Les algorithmes des réseaux sociaux sont conçus pour fonctionner dans ce sens, amplifiant les contenus viraux qui sont souvent ceux chargés d’émotions fortes et de controverses. C’est aussi pour cette raison que les réseaux sociaux jouent un rôle crucial dans l’amplification de la désinformation. En maximisant l’engagement des utilisateurs par des contenus émotionnellement chargés, ces plateformes facilitent la propagation de fausses informations, souvent plus attractives et plus sensationnalistes que des faits vérifiés. C’est pourquoi apprendre comment fonctionnent ces algorithmes est l’une des meilleures manières de combattre la désinformation.

Les IA génératives ajoutent une dimension supplémentaire à ces enjeux, car elles peuvent être détournées pour produire de la propagande ciblée, amplifier la désinformation ou créer des récits biaisés. Elles sont ainsi utilisées par des acteurs malveillants pour manipuler l’opinion publique, propager des narratifs faussement construits, et alimenter des discours idéologiques. Un récent rapport de Newsguard a démontré que les principales IA génératives du marché ont fait l’objet de manipulations au service de la propagande russe. Ces systèmes ne sont pas non plus exempts de biais idéologiques, comme Grok (X), instrumentalisé en faveur de Donald Trump lors de la campagne électorale présidentielle aux USA, ou DeepSeek, un nouveau venu au service de la propagande chinoise. Par ailleurs, une première étude sur l’impact cognitif des IA génératives souligne que celles-ci ne sont pas sans risques et mettent en danger notre capacité à développer et entretenir un esprit critique.

Est-ce que les IA pourraient favoriser, à la manière de Facebook dans les années 2010, un nouveau Printemps des peuples (qu’il soit Arabe, Africain ou dans une autre région du monde) ? Ou alors les dirigeants étatiques maitriseraient-ils la sphère numérique et ces nouvelles technologies, empêchant ainsi tout soulèvement ?

Les technologies de l’IA sont des instruments au service des humains. Elles ne sont ni bonnes ni mauvaises en elles-mêmes : elles sont ce que les individus en font. Dans le contexte des mouvements de contestation politiques, ce sont surtout les technologies numériques « classiques » qui sont utilisées. Dans de nombreux pays, les responsables politiques censurent régulièrement internet, en particulier en période électorale. L’ONG Netblocks permet de suivre cette censure en temps réel. Lors des printemps arabes, les manifestants ont contourné la censure en utilisant des VPN (réseaux privés virtuels) et des technologies de chiffrement pour préserver leur anonymat, accéder à l’information et partager des images et vidéos en temps réel.

De plus, de nombreux régimes autoritaires ont d’ores et déjà compris le potentiel des technologies de l’IA pour renforcer leur pouvoir, qu’il s’agisse de surveiller, contrôler ou manipuler. En Chine, par exemple, le système de crédit social est alimenté par des technologies de l’IA qui permettent de surveiller et d’évaluer en temps réel le comportement de chaque citoyen. Ce système repose sur la collecte de vastes quantités de données provenant de sources multiples, telles que les achats en ligne, les comportements sur les réseaux sociaux, les interactions avec les autorités, et même les actions quotidiennes comme traverser la rue ou respecter les règles de circulation. Les technologies de l’IA sont utilisées pour analyser ces données et attribuer une note de crédit social à chaque individu, qui peut influer sur leur accès à des services publics, leur capacité à voyager, ou encore leur réputation sociale. Ce système permet également d’évaluer la conformité idéologique des citoyens avec la vision du Parti communiste chinois.

Un tel système de surveillance de masse est impossible à mettre en place en Europe, en grande partie en raison des lois strictes qui protègent les droits fondamentaux des citoyens (règlement général sur la protection des données, loi sur l’IA). Toutefois, certaines exceptions ont été prévues notamment dans le cadre de la lutte contre le terrorisme, et ces exceptions doivent respecter des principes de proportionnalité et de nécessité. Par contre, de nombreuses plateformes en ligne fonctionnent sur base de notations qui, à l’instar du crédit social chinois, visent à influencer les actions futures des individus en se basant sur leur historique de comportement. Ici aussi, une bonne réputation peut entraîner des avantages, tandis qu’une mauvaise réputation peut entraîner des sanctions ou des restrictions d’accès.