Retranscription d’une interview à une étudiante de l’UBL, autour de l’intelligence artificielle, du journalisme et des fake news.

Quelles utilisations de l’IA dans les médias ?

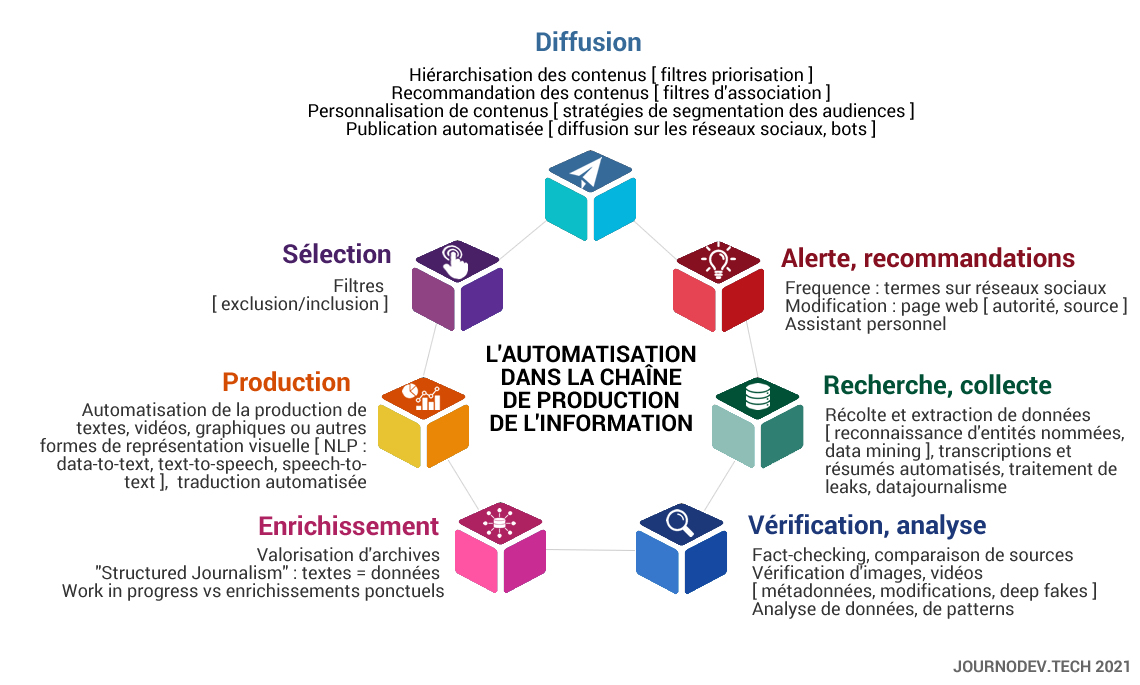

Potentiellement, les technologies d’intelligence artificielle peuvent couvrir l’ensemble de la chaine de production de l’information. On a beaucoup parlé de la production automatisée d’informations, car la production automatique de textes peut provoquer chez les journalistes de l’anxiété professionnelle, voire une perte d’identité professionnelle. Mais ce n’est pas la seule application possible, il y en a beaucoup d’autres. Vous-mêmes en avez peut-être déjà utilisé via un système de traduction ou de transcription automatique. Il faut se dire que ce sont des outils qui permettent de gagner du temps, souvent en travaillant avec d’importants volumes de données qu’il serait humainement fastidieux de traiter.

Quels types d’informations traite-t-elle ?

L’IA, c’est un assemblage d’algorithmes pour remplir une tâche déterminée. Un algorithme, c’est une procédure qui a pour objectif de résoudre un problème. Pour fonctionner, les technologies d’apprentissage par la machine ou d’apprentissage profond ont besoin d’énormes quantité de données. Bien que l’on se trouve dans un monde dont on dit qu’il se trouve dans un déluge de données, il n’est pas encore aussi évident de constituer de bons corpus et cela prend aussi du temps. Les algorithmes de machine learning se fondent sur des calculs probabilistes bayésiens qui consistent à calculer la probabilité de B étant donné A. On va retrouver, par exemple, les arbres décisionnels qui sont une aide à la décision en fonction d’une arborescence de résultats qui peuvent ou ne pas se produire. Comme tout cela repose sur des volumes importants de données, il faut se dire que si celles-ci sont biaisées ou incorrectes, le résultat sera lui aussi biaisé ou incorrect. Les technologies de l’IA peuvent être utilisées dans le secteur des médias, mais elles le sont sans doute beaucoup plus dans le monde de l’économie et de la finance, dans le monde médical mais aussi de plus en plus dans les ressources humaines et de la justice. La seule limite, ce sont donc les données.

Comment les IA permettent de générer des fake news ?

Générer des fake news ou de la vraie information ne repose pas sur des principes très différents, à partir du moment où on a des données à disposition. Ce qui va être important à prendre en considération, ce sont les intentions des personnes qui se trouvent derrière le système. Même si ces technologies « travaillent » de manière automatique, il ne faut pas oublier qu’il y a toujours des humains derrière qui fixent les règles et les procédures, c’est donc de ce côté-là qu’il faut chercher même si ce n’est pas toujours évident. Il n’est pas non plus impossible d’investiguer les algorithmes de machine learning, malgré leur complexité. Cela s’apprend. L’une des clés est de penser en termes de procédure. Le chercheur Nick Diakopoulos a mis au point une méthode qui consiste en du « reverse engineering » : on part du résultat pour comprendre le processus. Si on prend l’exemple concret de l’IA qui a généré de nouveaux morceaux de Jimi Hendrix, Nirvana ou Amy Winehouse, les données à la base étaient tout un catalogue de musiques. Maintenant, si l’on écoute bien cela en connaissant bien ces artistes, on se dit que oui, cela aurait pu être eux mais que non, ça ne l’est pas, car il manque une dimension humaine importante. GPT-3, l’IA développée par Open AI, est un autre exemple. Le système est capable de générer des textes de manière automatique. Son corpus de données, il le trouve en ligne, sur Wikipédia par exemple. Là, on se trouve face à un système complexe puisqu’il y a 175 milliards de paramètres. Mais la faille du système est qu’il ne comprend pas ce qu’il écrit puisqu’il travaille sur la probabilité que tel mot se retrouve à côté d’un autre. Les résultats peuvent être bluffant. Le système peut aussi composer de la musique, écrire de la poésie, créer des fictions, écrire du code informatique, générer des pages web en HTML… Dans le cas des deep fakes, ces vidéos plus vraies que nature, la technologie la plus courante est celle de l’apprentissage profond ou deep learning. Le trucage est obtenu par simulation : on apprend au système à reconnaître un visage source sous différents angles, puis on le transpose sur une cible, un peu comme un masque mais qui serait très réaliste.

Vrais outils de propagande, moteur de fake news ?

Tout dépend de l’intention que l’on retrouve derrière. SI on regarde d’un peu plus près, le phénomène des fake news, de la propagande, des infos complotistes, cela a toujours existé. On n’a pas attendu l’IA pour les inventer. Seulement, avec l’IA, on peut générer du faux par paquets et de manière rapide. Ce qui va surtout leur donner une caisse de résonance, ce sont les réseaux sociaux. Et c’est là que l’on se rend compte que si l’éducation aux médias est importante pour comprendre la manière dont ils fonctionnent, on a vraiment besoin aujourd’hui d’une éducation aux réseaux sociaux, voire à l’informatique. On manque souvent de distance critique face à tout cela et c’est ce qui est sans doute tout aussi dangereux que le phénomène des fake news en lui-même. Quelles sont les fake news qui ont occupé le devant de la scène récemment ? Il y en a eu beaucoup dans des contextes politiques et électoraux, l’objet étant clairement la manipulation. Il y en a aussi beaucoup dans le contexte de la pandémie. Mais cela ne part pas nécessairement d’une IA. Une fausse information peut être balancée par un seul quidam et puis être reprise par des centaines de milliers. L’objectif dans tout cela, c’est d’influencer l’opinion publique.

L’IA, une menace pour l’homme dans le contexte des médias ?

Il faut avant tout voir les technologies de l’IA comme des outils qui peuvent aider les rédactions à mieux travailler ou à faire gagner du temps aux journalistes pour se concentrer sur des tâches plus valorisantes. Le projet de recherche Journalism AI a montré que près de quatre rédactions sur dix avaient déjà déployé des stratégies en matière d’intelligence artificielle. Les principaux obstacles au développement de ces technologies sont à trouver dans les résistances culturelles liées à des craintes de pertes d’emploi, de modifications des routines de travail, voire d’une hostilité plus générale à l’encontre des technologies. Mais elles sont également liées à un coût élevé de développement. Ceci explique pourquoi les entreprises de grande taille y aient davantage accès. Pourrait-on faire un média sans journalistes ? C’est une question qui taraude sans doute quelques uns mais la réponse est non, et en tout cas pas pour l’instant. La dimension humaine et intellectuelle du journaliste est essentielle, tout comme son rapport aux sources : tout cela ne se trouve pas dans des bases de données. A ce jour, la seule entreprise qui a licencié massivement des journalistes pour les remplacer par des programmes informatiques, c’est Microsoft pour son portail MSN, qui n’est donc pas un véritable média d’information.

Comment ne pas se faire berner ?

On n’est jamais à l’abri d’une trop grande naïveté mais la distance critique reste la meilleure arme. Si la source n’est pas vérifiée, fiable, il faut se méfier. L’outil NewsGuard, par exemple, indique sur le navigateur web si un site d’information est fiable et crédible. Il est paramétré par des humains, le gage de qualité si on peut dire ça comme ça. La RTBF a aussi développé Faky qui permet d’évaluer la fiabilité d’une information. Ici, on a un système informatisé qui travaille un peu comme un super agrégateur à partir de plusieurs sources. Mais ce « fact-checking » ne concerne pas seulement les médias d’information. Cela peut aussi s’appliquer aux discours politiques, qui peuvent dire tout et leur contraire. Le Washington Post avit développé un outil qui s’appelait Truth Teller et qui allait dans ce sens. Dans le cas des deep fakes, c’est-à-dire des fausses vidéos qui ont l’air aussi vraies que nature, c’est plus compliqué. Mais l’intelligence artificielle peut aussi venir à la rescousse pour vérifier si la vidéo est un faux. L’outil Counter Social propose un détecteur de deep fakes. Mais quel est l’internaute qui va prendre le temps de télécharger une vidéo puis de la vérifier ? Pour les journalistes, par contre, c’est un outil très utile. En ce qui concerne les images, on peut travailler avec des moteurs de recherche inversés, qui permettent de retrouve une image originale, le nombre de fois qu’elle a été modifiée etc. Aujourd’hui, il existe de plus en plus d’outils de fact-checking en ligne mais leur nombre reste, malgré tout, assez limité. On peut aussi regarder les métadonnées d’un fichier informatique, c’est-à-dire les informations sur le fichier, qui peuvent donner des indications sur la date de création, la date de modification ou l’auteur. Tout cela, c’est aussi la preuve qu’on a plus que jamais besoin de journalistes pour débusquer tout cela.