Plusieurs tests ont été nécessaires pour calibrer les requêtes, celles-ci se montrant moins performantes lorsqu’un # est utilisé. Une veille des tendances affichées sur Twitter a également conduit à l’ajout des mots-clés ARN et mRNA, puisque l’analyse du corpus sera réalisée en français et en anglais. Au total, quatre variables sont récupérées (pour quatre fichiers quotidiens, donc).

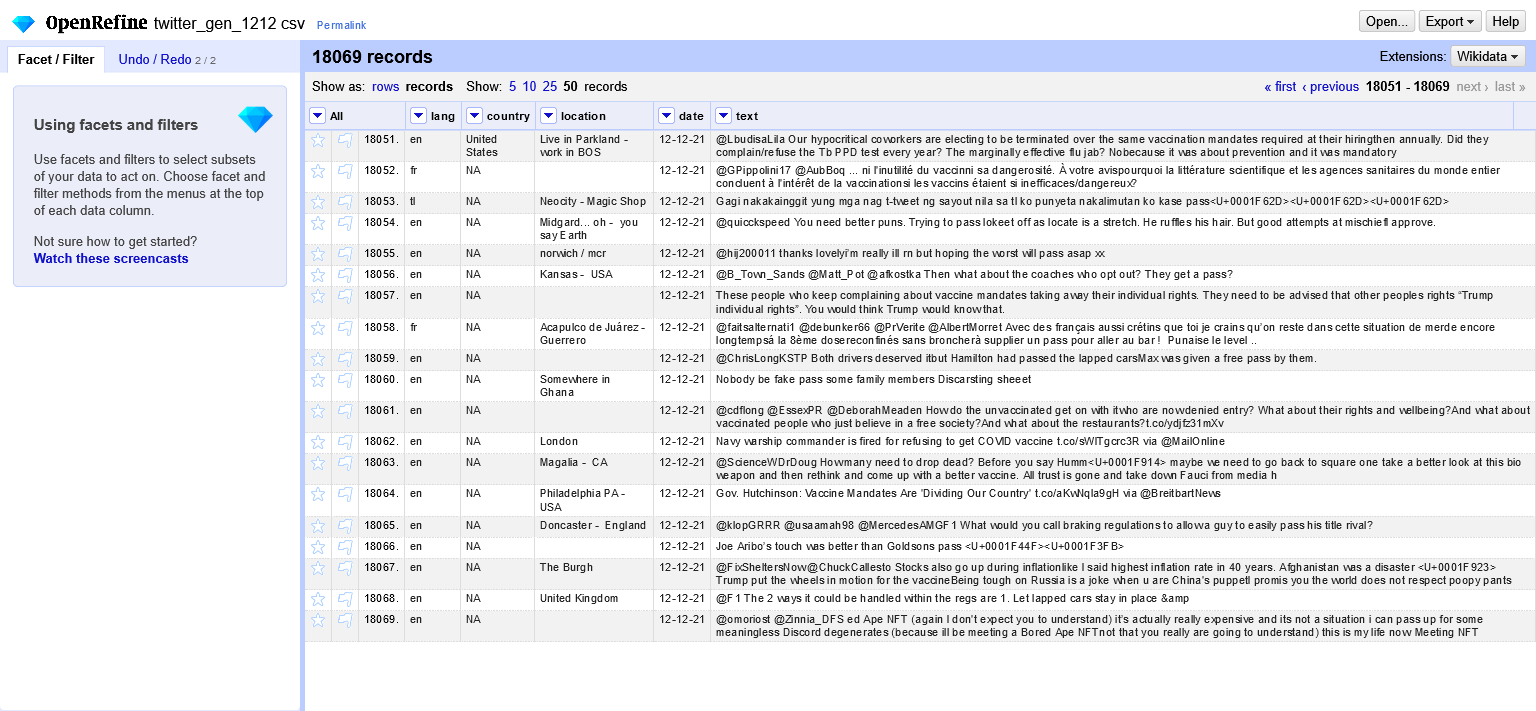

Chaque jeu de données est nettoyé via Open Refine : des fusions de colonnes sont parfois nécessaires car la colonne « text » est parfois scindée en plusieurs colonnes (enregistrement avec séparateur de virgule). Les trois corpus relatifs à une zone géographique définie présentent moins de problèmes de qualité que le corpus général, qui cible tous azimuts : big data ne veut pas forcément bonne data, cela se vérifie une fois de plus dans ce cas. Nous en sommes à trois jours de scraping. Ces actions vont se répéter quotidiennement avant d’aboutir à quatre corpus qui tiennent la route avant de pouvoir être analysés.

Lectures du jour :

- Deng, S., Sinha, A. P., & Zhao, H. (2017). Adapting sentiment lexicons to domain-specific social media texts. Decision Support Systems, 94, 65-76.

- Mowlaei, M. E., Abadeh, M. S., & Keshavarz, H. (2020). Aspect-based sentiment analysis using adaptive aspect-based lexicons. Expert Systems with Applications, 148, 113234.